[인더스트리뉴스 최종윤 기자] 국내 연구진이 인공지능(AI) 등에 널리 사용되는 그래픽 연산 장치(이하 GPU)에서 메모리 크기의 한계로 인해 초병렬 연산의 결과로 대규모 출력 데이터가 발생할 때 이를 잘 처리하지 못하던 난제를 해결했다.

이 기술을 통해 향후 가정에서 사용하는 메모리 크기가 작은 GPU로도 생성형 AI 등 고난이도 연산이 대규모 출력을 필요한 경우 이를 빠르게 수행할 수 있다.

KAIST(총장 이광형)는 전산학부 김민수 교수 연구팀이 한정된 크기의 메모리를 지닌 GPU를 이용해 수십, 수백 만개 이상의 스레드들로 초병렬 연산을 하면서 수 테라바이트의 큰 출력 데이터를 발생시킬 경우에도 메모리 에러를 발생시키지 않고 해당 출력 데이터를 메인 메모리로 고속으로 전송 및 저장할 수 있는 데이터 처리 기술(일명 INFINEL)을 개발했다고 지난 7일 밝혔다.

최근 AI의 활용이 급속히 증가하면서 지식 그래프와 같이 정점과 간선으로 이루어진 그래프 구조의 데이터의 구축과 사용도 점점 증가하고 있는데, 그래프 구조의 데이터에 대해 난이도가 높은 초병렬 연산을 수행할 경우 그 출력 결과가 매우 크고, 각 스레드의 출력 크기를 예측하기 어렵다는 문제점이 발생한다.

또한 GPU는 근본적으로 CPU와 달리 메모리 관리 기능이 매우 제한적이기 때문에 예측할 수 없는 대규모의 데이터를 유연하게 관리하기 어렵다는 문제가 있다. 이러한 이유로 지금까지는 GPU를 활용해 ‘삼각형 나열’과 같은 난이도가 높은 그래프 초병렬 연산을 수행할 수 없었다.

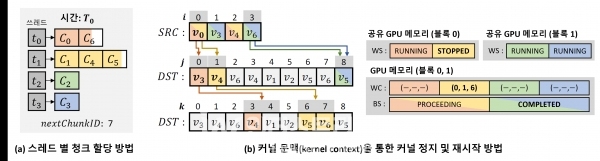

김 교수팀은 이를 근본적으로 해결하는 INFINEL 기술을 개발했다. 해당 기술은 GPU 메모리의 일부 공간을 수백 만개 이상의 청크(chunk)라 불리는 매우 작은 크기의 단위들로 나누고 관리하면서, 초병렬 연산 내용이 담긴 GPU 커널(kernel) 프로그램을 실행하면서 각 스레드가 메모리 충돌 없이 빠르게 자신이 필요한 청크 메모리들을 할당받아 자신의 출력 데이터를 저장할 수 있도록 한다.

또한 GPU 메모리가 가득 차도 무중단 방식으로 초병렬 연산과 결과 출력 및 저장을 지속할 수 있도록 한다. 따라서 이 기술을 사용하면 가정에서 사용하는 메모리 크기가 작은 GPU로도 수 테라 바이트 이상의 출력 데이터가 발생하는 고난이도 연산을 빠르게 수행할 수 있다.

그림(b): Kernel context를 통한 커널 런타임 중 커널 정지 및 재시작 기술을 나타낸다. 3개의 배열 자료구조를 통해 동작하며, 와프에 속한 모든 쓰레드들의 문맥를 압축적으로 저장하는 WC(warp context array), 와프별 계속 진행 중인지 멈췄는 지를 저장해 와프 내 다른 모든 쓰레드들이 동일 시점에 멈출 수 있도록 하는 WS(warp state array), 쓰레드 블록 별로 질의가 완료됐는지 안됐는지를 저장하는 BS(block state array)로 구성된다. 3개의 배열을 GPU 메모리 또는 GPU 공유 메모리에 저장해 매우 작은 시간적 비용으로 동작할 수 있도록 관리한다. [자료=카이스트]

김민수 교수 연구팀은 INFINEL 기술의 성능을 다양한 실험 환경과 데이터 셋을 통해 검증했으며, 종래의 최고 성능 동적 메모리 관리자 기술에 비해 약 55배, 커널을 2번 실행하는 2단계 기술에 비해 약 32배 연산 성능을 향상함을 보였다.

교신저자로 참여한 KAIST 전산학부 김민수 교수는 “생성형 AI나 메타버스 시대에는 GPU 컴퓨팅의 대규모 출력 데이터를 빠르게 처리할 수 있는 기술이 중요해질 것으로 예상되며, INFINEL 기술이 그 일부 역할을 할 수 있을 것”이라고 말했다.

이번 연구에는 김 교수의 제자인 박성우 박사과정이 제1 저자로, 김 교수가 창업한 그래프 딥테크 기업인 그래파이 소속의 오세연 연구원이 제2 저자로, 김 교수가 교신 저자로 참여했으며, 국제 학술지 ‘PPoPP’에 3월 4일자로 발표됐다.

한편, 이번 연구는 과기정통부 IITP SW스타랩 및 ITRC 사업, 한국연구재단 선도연구센터인 암흑데이터 극한 활용 연구센터의 지원을 받아 수행됐다.

- KAIST, 해킹 공격 막는 암호 반도체 최초 개발

- KAIST, 생성형 인공지능·가상현실 결합한 3D 스케칭 연구 본격화

- KAIST, IoT 혁신 위한 핵심 신소재 소개… “자기조립 나노패턴, 포스트 AI 시대에 중요 역할 할 것”

- KAIST-현대자동차, 세계 최초 미국 에너지청 기준 성능을 충족하는 수소센서 개발

- 국내 연구진, 실리콘 진동자로 뉴로모픽 진동 신경망 구현… “복잡한 컴퓨팅 난제 해결”

- 과기정통부, 인공지능 시대 클라우드 정책방향 수립에 본격 착수

- 12년 사용하는 리튬인산철 배터리 나온다… KAIST, 장수명 배터리 기술개발

- “정보처리 기술 기틀 세울 수 있을 것ˮ… KAIST, 세계 최초 ‘마그논 오비탈 홀 효과’ 발견

- ‘뉴로모픽 컴퓨팅’ 신뢰성 문제 풀렸다… KAIST, 한양대와 차세대 메모리 관련 연구 진행

- KAIST, 자율주행차·로봇 등 온디바이스 환경서 적응형 인공지능 실현

- 스마트폰으로 손쉽게 '가짜 분유' 걸러낸다